❖본 조사 보고서의 견적의뢰 / 샘플 / 구입 / 질문 폼❖

AI 컴퓨팅 하드웨어 시장 개요 (2026-2031)

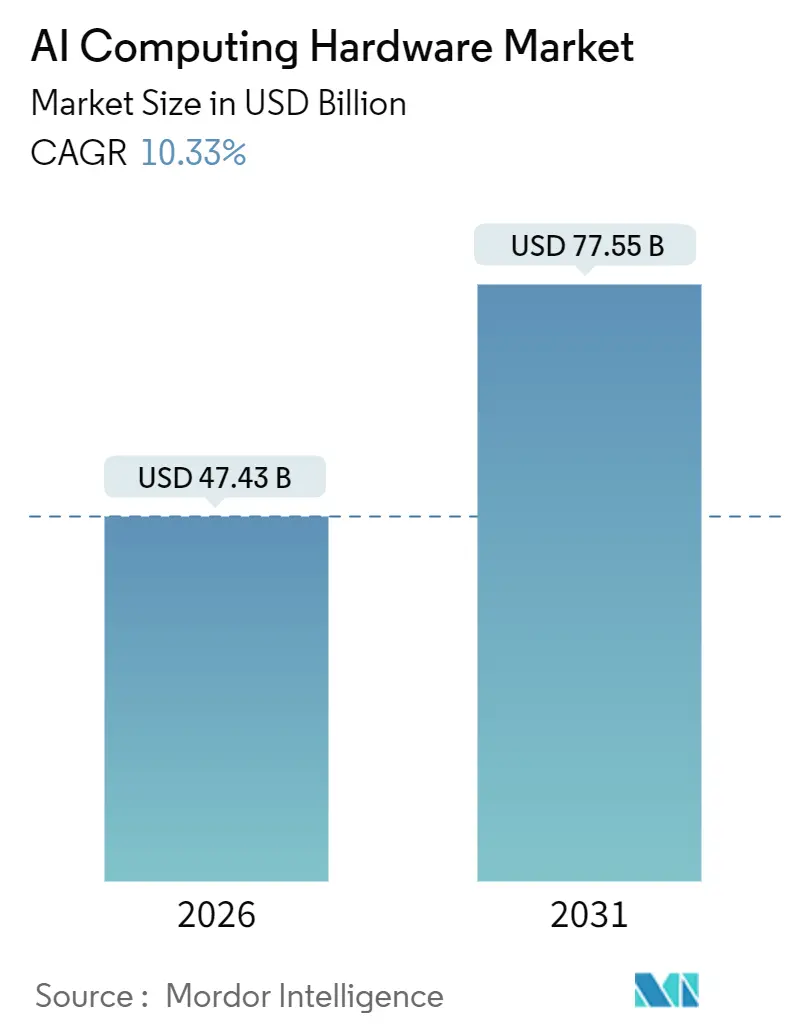

AI 컴퓨팅 하드웨어 시장은 2026년 474억 3천만 달러에서 2031년 775억 5천만 달러 규모로 성장할 것으로 전망되며, 예측 기간 동안 연평균 10.33%의 견고한 성장률을 기록할 것으로 예상됩니다. 이러한 성장은 주로 시스템 설계의 변화, 특히 추론(Inference) 워크로드가 프로덕션 배포를 지배하면서 용량 계획, 인프라 설계 및 가속기 선택을 재편하는 데 기인합니다. 북미가 가장 큰 시장 점유율을 차지하고 있으며, 아시아 태평양 지역은 가장 빠른 성장세를 보일 것으로 예측됩니다. 시장 집중도는 낮은 편입니다.

주요 시장 분석 및 동향

AI 컴퓨팅 하드웨어 시장은 확장 가능하고 프로덕션 등급의 추론을 반복적인 지출의 주요 동인으로 재조정하고 있으며, 실시간 서비스에 대한 이러한 강조는 운영자 전반의 열, 네트워킹 및 메모리 설계 선택에 영향을 미치고 있습니다. 랙 레벨 통합 및 코패키지드 옵틱스(Co-packaged Optics)는 운영자들이 비트당 전력을 줄이고 대규모 훈련 및 추론 패브릭에서 클러스터 복원력을 향상시키기 위해 노력함에 따라 주목받고 있습니다. 전력 가용성, 메모리 공급 및 수출 정책은 주요 마찰 지점으로 남아 있지만, 장기 계약 및 사전 약정된 전력 전략은 AI 컴퓨팅 하드웨어 시장의 투자 결정을 안정화하는 데 도움이 됩니다.

주요 보고서 요약

* 컴퓨팅 실리콘 유형: GPU 가속기가 2025년 매출의 64%를 차지하며 선두를 유지했으나, AI ASIC은 2031년까지 10.6%의 연평균 성장률로 가장 빠르게 성장할 것으로 예상됩니다.

* 시스템 폼 팩터: AI 서버가 2025년 78%의 점유율로 지배적이었으며, 통합 랙 스케일 플랫폼은 2031년까지 10.7%의 연평균 성장률로 가장 높은 성장을 기록했습니다.

* 배포 위치: 클라우드 데이터 센터가 2025년 44%의 점유율을 차지했으며, 엣지 및 엔드포인트 사이트는 2025년부터 2031년까지 10.9%의 연평균 성장률로 가장 빠르게 성장했습니다.

* 워크로드 유형: 추론이 2025년 35%의 점유율을 기록했으며, 2031년까지 11.2%의 연평균 성장률로 발전할 것으로 예상됩니다.

* 최종 사용자 산업: 하이퍼스케일러 및 클라우드 서비스 제공업체가 2025년 지출의 57.4%를 차지했으며, 헬스케어 및 생명 과학 분야는 2031년까지 10.9%의 연평균 성장률로 증가했습니다.

* 지역: 북미가 2025년 35.7%의 매출 점유율을 기록했으며, 아시아 태평양 지역은 2031년까지 11.0%의 연평균 성장률로 성장을 주도할 것으로 전망됩니다.

시장 동인 및 영향

* 하이퍼스케일러 AI 인프라 자본 지출 확대 (+3.2% CAGR 영향): 하이퍼스케일러의 AI 인프라 투자는 서버, 가속기, 고속 네트워킹 패브릭 및 액체 냉각 랙 설계에 집중되며, 대규모 배포는 운영자 수요의 규모와 지속성을 입증합니다.

* 훈련에서 추론으로의 전환으로 컴퓨팅 볼륨 증가 (+2.8% CAGR 영향): 컴퓨팅 사이클의 균형이 추론으로 이동하면서, 토큰당 비용, 낮은 지연 시간 및 효율적인 메모리 계층에 최적화된 가속기 및 시스템에 대한 수요가 증가하고 있습니다.

* 하이엔드 AI GPU 및 랙 스케일 시스템의 빠른 제품 주기 (+1.7% CAGR 영향): 선도적인 공급업체들은 가속화된 업데이트 주기로 운영하며, 랙 스케일 플랫폼은 컴퓨팅, 고대역폭 네트워킹 및 액체 냉각을 통합하여 빠른 시운전과 일관된 성능을 제공합니다.

* 가속 서버가 AI 인프라 지출 지배 (+2.1% CAGR 영향): GPU 및 맞춤형 가속기를 내장한 서버가 AI 인프라 지출의 대부분을 차지하며, 대규모 트랜스포머 모델 및 스케일아웃 훈련에는 수천 개의 긴밀하게 연결된 가속기가 필요합니다.

* 고대역폭 상호 연결을 위한 코패키지드 옵틱스 채택 (+0.8% CAGR 영향): 데이터 센터 패브릭에서 코패키지드 옵틱스가 부상하여 비트당 전력을 줄이고 시스템 복원력을 향상시킵니다.

* 액체 냉각 침투로 고-TDP AI 시스템 구현 (+1.5% CAGR 영향): 액체 냉각의 광범위한 채택은 고밀도 및 지속적인 부하 프로파일을 관리하는 데 필수적이며, 고-TDP 가속기 로드맵과 일치하는 모듈식 전력 아키텍처를 가능하게 합니다.

시장 제약 및 영향

* AI 데이터 센터의 전력 및 그리드 제약 (-2.3% CAGR 영향): 주요 대도시 지역의 전력 가용성 및 상호 연결 일정 제약은 대규모 캠퍼스의 시운전 일정을 연장시키며, 액체 냉각 및 모듈식 전력 아키텍처 채택을 촉진합니다.

* HBM 및 고급 패키징 공급 제약 (-1.9% CAGR 영향): 고대역폭 메모리(HBM) 및 고급 패키징은 가속기 출하량의 제한 요소로 남아 있으며, 수요 증가는 단기적으로 가용 용량에 압력을 가합니다.

* 수출 통제 및 기술 분열 (-0.7% CAGR 영향): 미국-중국 기술 회랑을 따라 발생하는 수출 통제는 국경 간 용량 할당 및 칩 가용성에 대한 계획 복잡성을 증가시킵니다.

* 고급 냉각의 서비스 용이성 및 생태계 복잡성 (-0.4% CAGR 영향): 특히 기존 시설의 개조 시나리오에서 고급 냉각 솔루션의 서비스 용이성 및 복잡성은 제약으로 작용합니다.

세그먼트별 분석

* 컴퓨팅 실리콘 유형: GPU 가속기는 성숙한 소프트웨어 스택과 숙련된 엔지니어링 인력으로 인해 높은 전환 비용을 유지하며 지배적입니다. 그러나 대규모 운영자들이 프로덕션 추론을 위한 토큰당 효율성과 워크로드 정렬을 우선시함에 따라 AI ASIC이 가장 빠르게 성장하고 있습니다.

* 시스템 폼 팩터: AI 서버가 지배적인 점유율을 유지하는 가운데, 전력 밀도와 액체 냉각 환경에서의 예측 가능한 성능 및 단순화된 시운전을 제공하는 통합 랙 스케일 솔루션이 가장 빠르게 성장하고 있습니다.

* 배포 위치: 훈련 및 대규모 추론 클러스터는 고전력 밀도와 고급 네트워킹을 갖춘 전용 사이트를 선호하여 클라우드 데이터 센터가 큰 비중을 차지합니다. 반면, 지연 시간에 민감한 추론이 사용자에게 더 가까이 이동함에 따라 엣지 및 엔드포인트 사이트가 가장 빠르게 성장하고 있습니다.

* 워크로드 유형: 추론은 초기 모델 훈련 후 지속적인 서비스 워크로드의 특성을 반영하여 가장 높은 성장률을 보입니다. 이는 토큰당 비용, 와트당 처리량 및 첫 토큰까지의 시간을 중요하게 여기는 설계 선택을 유도합니다.

* 최종 사용자 산업: 하이퍼스케일러 및 클라우드 서비스 제공업체가 훈련 및 추론에 대한 수요를 통합하여 지출의 대부분을 차지합니다. 헬스케어 및 생명 과학 분야는 진단 영상, 임상 의사 결정 지원 및 규제 준수 요구 사항으로 인해 높은 성장률을 기록하고 있습니다.

지역별 분석

북미는 글로벌 하이퍼스케일러의 본사, 플랫폼 엔지니어링 및 고급 설계 파트너십이 집중되어 2025년 매출의 35.7%를 차지합니다. 아시아 태평양 지역은 주권 클라우드 이니셔티브와 지역 디지털 서비스가 현지 컴퓨팅 발자국을 증가시키면서 2031년까지 11.0%의 연평균 성장률로 가장 빠른 확장을 보입니다. 유럽은 데이터 상주 및 전력 가용성의 균형을 맞추고 있으며, 중동은 서구 기술 스택을 보완하는 대규모 AI 인프라에 지속적으로 투자하고 있습니다. 수출 통제는 미국-중국 회랑을 따라 소싱 및 배포 결정에 영향을 미치며, 이는 국경 간 용량 할당 및 칩 가용성에 대한 계획 복잡성을 야기합니다.

경쟁 환경

AI 컴퓨팅 하드웨어 시장은 적당한 통합 수준을 보이며, 한 공급업체가 2025년까지 AI 가속기 시장의 거의 70%를 점유하고 있습니다. NVIDIA는 GPU, 패브릭 및 소프트웨어를 결합한 풀 스택 접근 방식으로 선두를 유지하고 있습니다. AMD는 개방적이고 상호 운용 가능한 접근 방식을 추진하며 액체 냉각 및 네트워킹을 통합한 랙 스케일 플랫폼을 제공합니다. Intel과 NVIDIA는 맞춤형 x86 CPU와 NVIDIA AI 플랫폼을 통합하는 전략적 협력을 발표했습니다. 이러한 움직임은 패키지형 랙 솔루션 및 통합 패브릭으로의 시장 전환과 일치합니다. 액체 냉각 공급업체 및 전력 분배 공급업체는 시스템 성능, 서비스 용이성 및 가동 시간에 핵심적인 역할을 하며, 코패키지드 옵틱스 채택은 비트당 전력을 줄이고 패브릭 견고성을 향상시킵니다.

최근 산업 발전

* 2026년 1월: AMD는 CES 2026에서 Ryzen AI 400 시리즈 프로세서를 확장하고 로컬 대규모 모델 개발 및 추론을 위한 미니 PC인 Ryzen AI Halo 개발자 플랫폼을 발표했습니다.

* 2025년 10월: AMD는 OCP 2025 서밋에서 Open Rack Wide 사양을 기반으로 하고 다가오는 Instinct 가속기를 중심으로 하는 Helios 랙 스케일 AI 플랫폼을 공개하며 하이퍼스케일 AI를 위한 개방형 상호 운용성을 강조했습니다.

* 2025년 10월: Micron은 AI 데이터 센터용 192GB SOCAMM2 LPDDR5X 모듈 샘플링을 발표하며 실시간 추론을 위한 첫 토큰까지의 시간 단축 및 액체 냉각 서버의 서비스 용이성 향상을 언급했습니다.

* 2025년 9월: Intel과 NVIDIA는 NVLink를 통해 통합된 NVIDIA 맞춤형 x86 CPU 및 NVIDIA GPU 칩렛이 포함된 PC SoC를 포함하여 AI 인프라 및 개인 컴퓨팅 제품을 공동 개발하기 위한 파트너십을 발표했습니다.

이 보고서는 AI 컴퓨팅 하드웨어 시장에 대한 심층 분석을 제공합니다. AI 컴퓨팅 하드웨어는 AI 애플리케이션의 더 빠른 처리를 가능하게 하는 마이크로프로세서 또는 마이크로칩을 의미하며, 독립형 비전 프로세서 및 임베디드 사운드 프로세서 등을 포함합니다. 시장은 2026년 474.3억 달러 규모에서 2031년 775.5억 달러 규모로 연평균 10.3%의 성장률을 보일 것으로 전망됩니다.

시장의 주요 성장 동력으로는 하이퍼스케일러의 AI 인프라 자본 지출 확대, AI 워크로드의 훈련(Training)에서 추론(Inference)으로의 전환에 따른 컴퓨팅 볼륨 증가, 고성능 AI GPU 및 랙 스케일 시스템의 빠른 제품 출시 주기, AI 인프라 지출에서 가속화 서버의 지배력, 고대역폭 상호 연결을 위한 코패키지드 광학(Co-Packaged Optics) 채택, 그리고 더 높은 TDP(열 설계 전력) AI 시스템을 가능하게 하는 액체 냉각(Liquid Cooling) 기술의 확산이 있습니다.

반면, 시장 성장을 저해하는 요인으로는 AI 데이터센터의 전력 및 전력망 제약, HBM(고대역폭 메모리) 및 첨단 패키징 분야의 공급 제약, 수출 통제 및 기술 분열, 그리고 첨단 냉각 시스템의 서비스 용이성 및 생태계 복잡성 등이 지목됩니다.

보고서는 컴퓨팅 실리콘 유형, 시스템 폼 팩터, 배포 위치, 워크로드 유형, 최종 사용자 산업 및 지역별로 시장을 세분화하여 분석합니다.

* 컴퓨팅 실리콘 유형별: GPU 가속기가 2025년 시장 점유율 64%로 선두를 유지하며, AI ASIC은 2031년까지 연평균 10.6%로 가장 빠르게 성장할 것으로 예상됩니다.

* 배포 위치별: 클라우드 데이터센터가 2025년 44%의 점유율로 가장 큰 비중을 차지하지만, 대기 시간에 민감한 추론 워크로드가 사용자에게 더 가까워지면서 엣지 및 엔드포인트 배포가 연평균 10.9%로 가장 빠르게 확장될 것입니다.

* 워크로드 유형별: 추론 워크로드가 2025년 35%의 점유율과 연평균 11.2%의 성장률로 핵심적인 역할을 하며, 토큰당 비용, 메모리 용량 및 전력 효율성에 대한 설계 우선순위를 변화시키고 있습니다.

* 최종 사용자 산업별: 하이퍼스케일러 및 클라우드 서비스 제공업체가 2025년 지출의 57.4%를 차지하며 시장을 주도하고, 헬스케어 및 생명 과학 분야가 연평균 10.9%로 가장 빠르게 성장하는 부문으로 나타났습니다.

* 지역별: 북미가 2025년 35.7%의 점유율로 시장을 선도하며, 아시아 태평양 지역은 2031년까지 연평균 11.0%로 가장 빠른 성장률을 보일 것으로 전망됩니다.

경쟁 환경 분석에서는 시장 집중도, 주요 기업들의 전략적 움직임, 시장 점유율 분석 및 NVIDIA, AMD, Intel, Huawei, IBM, Dell, HPE, Super Micro Computer, Lenovo, Inspur 등 주요 하드웨어 공급업체와 Amazon, Google, Microsoft, Baidu, Alibaba, Tencent와 같은 클라우드 서비스 제공업체 및 Cerebras Systems, Graphcore, Tenstorrent, Groq, SambaNova Systems 등 전문 AI 칩 개발사를 포함한 다양한 기업들의 프로필을 다룹니다. 보고서는 또한 시장 기회와 미래 전망, 특히 미개척 영역 및 충족되지 않은 요구 사항에 대한 평가를 제공합니다.

1. 서론

- 1.1 연구 가정 및 시장 정의

- 1.2 연구 범위

2. 연구 방법론

3. 요약

4. 시장 환경

- 4.1 시장 개요

- 4.2 시장 동인

- 4.2.1 하이퍼스케일러 AI 인프라 자본 지출 확장

- 4.2.2 훈련에서 추론으로의 전환으로 컴퓨팅 볼륨 증가

- 4.2.3 하이엔드 AI GPU 및 랙 스케일 시스템의 빠른 제품 주기

- 4.2.4 가속 서버가 AI 인프라 지출을 지배

- 4.2.5 고대역폭 상호 연결을 위한 코패키지드 광학 채택

- 4.2.6 액체 냉각 보급으로 더 높은 TDP AI 시스템 구현

- 4.3 시장 제약

- 4.3.1 AI 데이터 센터의 전력 및 그리드 제약

- 4.3.2 HBM 및 고급 패키징의 공급 제약

- 4.3.3 수출 통제 및 기술 분열

- 4.3.4 고급 냉각을 위한 서비스 용이성 및 생태계 복잡성

- 4.4 산업 가치 / 공급망 분석

- 4.5 규제 환경

- 4.6 기술 전망

- 4.7 거시 경제 요인이 시장에 미치는 영향

- 4.8 포터의 5가지 경쟁 요인 분석

- 4.8.1 신규 진입자의 위협

- 4.8.2 공급업체의 교섭력

- 4.8.3 구매자의 교섭력

- 4.8.4 대체재의 위협

- 4.8.5 산업 내 경쟁

5. 시장 규모 및 성장 예측 (가치 및 물량)

- 5.1 컴퓨팅 실리콘 유형별

- 5.1.1 GPU 가속기

- 5.1.2 AI ASIC

- 5.1.3 FPGA

- 5.1.4 CPU

- 5.1.5 NPU (엣지)

- 5.1.6 기타 컴퓨팅 실리콘 유형

- 5.2 시스템 폼 팩터별

- 5.2.1 AI 서버

- 5.2.2 가속기 카드 및 모듈 (PCIe, OAM, SXM)

- 5.2.3 통합 시스템 및 어플라이언스

- 5.2.4 엣지 장치 및 게이트웨이

- 5.2.5 기타 시스템 폼 팩터

- 5.3 배포 위치별

- 5.3.1 클라우드 데이터 센터

- 5.3.2 기업 및 온프레미스 데이터 센터

- 5.3.3 엣지 및 엔드포인트

- 5.3.4 기타 배포 위치

- 5.4 워크로드 유형별

- 5.4.1 훈련

- 5.4.2 추론

- 5.4.3 기타 워크로드 유형

- 5.5 최종 사용자 산업별

- 5.5.1 하이퍼스케일러 및 클라우드 서비스 제공업체

- 5.5.2 기술 및 인터넷 기업

- 5.5.3 금융 서비스

- 5.5.4 의료 및 생명 과학

- 5.5.5 자동차 및 제조

- 5.5.6 통신

- 5.5.7 소매 및 소비자

- 5.5.8 공공 부문

- 5.5.9 기타 최종 사용자 산업

- 5.6 지역별

- 5.6.1 북미

- 5.6.1.1 미국

- 5.6.1.2 캐나다

- 5.6.1.3 멕시코

- 5.6.2 남미

- 5.6.2.1 브라질

- 5.6.2.2 아르헨티나

- 5.6.2.3 칠레

- 5.6.2.4 남미 기타 지역

- 5.6.3 유럽

- 5.6.3.1 독일

- 5.6.3.2 영국

- 5.6.3.3 프랑스

- 5.6.3.4 이탈리아

- 5.6.3.5 스페인

- 5.6.3.6 네덜란드

- 5.6.3.7 러시아

- 5.6.3.8 유럽 기타 지역

- 5.6.4 아시아 태평양

- 5.6.4.1 중국

- 5.6.4.2 일본

- 5.6.4.3 대한민국

- 5.6.4.4 인도

- 5.6.4.5 호주

- 5.6.4.6 싱가포르

- 5.6.4.7 대만

- 5.6.4.8 아시아 태평양 기타 지역

- 5.6.5 중동

- 5.6.5.1 아랍에미리트

- 5.6.5.2 사우디아라비아

- 5.6.5.3 튀르키예

- 5.6.5.4 이스라엘

- 5.6.5.5 중동 기타 지역

- 5.6.6 아프리카

- 5.6.6.1 남아프리카 공화국

- 5.6.6.2 이집트

- 5.6.6.3 나이지리아

- 5.6.6.4 아프리카 기타 지역

6. 경쟁 환경

- 6.1 시장 집중도

- 6.2 전략적 움직임

- 6.3 시장 점유율 분석

- 6.4 기업 프로필

- 6.4.1 엔비디아 코퍼레이션

- 6.4.2 어드밴스드 마이크로 디바이시스, Inc.

- 6.4.3 인텔 코퍼레이션

- 6.4.4 화웨이 테크놀로지스 Co., Ltd.

- 6.4.5 인터내셔널 비즈니스 머신즈 코퍼레이션

- 6.4.6 델 테크놀로지스 Inc.

- 6.4.7 휴렛 팩커드 엔터프라이즈 컴퍼니

- 6.4.8 슈퍼 마이크로 컴퓨터, Inc.

- 6.4.9 레노버 그룹 리미티드

- 6.4.10 인스퍼 전자 정보 산업 Co., Ltd.

- 6.4.11 아마존닷컴, Inc.

- 6.4.12 구글 LLC

- 6.4.13 마이크로소프트 코퍼레이션

- 6.4.14 바이두, Inc.

- 6.4.15 알리바바 그룹 홀딩 리미티드

- 6.4.16 텐센트 홀딩스 리미티드

- 6.4.17 세레브라스 시스템즈 Inc.

- 6.4.18 그래프코어 리미티드

- 6.4.19 텐스토렌트, Inc.

- 6.4.20 그록, Inc.

- 6.4.21 삼바노바 시스템즈, Inc.

- 6.4.22 퀄컴 인코퍼레이티드

- 6.4.23 암 홀딩스 plc

- 6.4.24 암페어 컴퓨팅 LLC

- *목록은 전부가 아님

7. 시장 기회 및 미래 전망

❖본 조사 보고서에 관한 문의는 여기로 연락주세요.❖

AI 컴퓨팅 하드웨어는 인공지능(AI) 모델의 학습(training) 및 추론(inference) 작업을 효율적으로 수행하기 위해 특별히 설계되거나 최적화된 물리적 구성 요소를 총칭합니다. 이는 기존의 범용 컴퓨팅 하드웨어와 달리, AI 연산에 특화된 병렬 처리 능력, 고대역폭 메모리, 저지연 통신 등을 제공하여 AI 워크로드의 성능과 전력 효율성을 극대화하는 것을 목표로 합니다. 방대한 데이터 처리, 복잡한 행렬 연산, 심층 신경망 가속 등 AI 알고리즘의 핵심 요구사항을 충족시키기 위해 개발되고 있습니다.

AI 컴퓨팅 하드웨어의 종류는 다양합니다. 가장 대표적인 것은 GPU(Graphics Processing Unit)로, 엔비디아(NVIDIA)의 CUDA 플랫폼을 중심으로 AI 학습 및 추론의 사실상 표준으로 자리 잡았습니다. GPU는 대규모 병렬 처리 능력으로 딥러닝 모델 학습에 필수적인 역할을 수행합니다. 다음으로 TPU(Tensor Processing Unit)는 구글(Google)이 AI 워크로드에 최적화하기 위해 자체 개발한 ASIC(Application-Specific Integrated Circuit)의 일종으로, 특히 텐서 연산에 특화되어 클라우드 환경에서 효율적인 AI 연산을 제공합니다. NPU(Neural Processing Unit)는 스마트폰, 엣지 디바이스 등 저전력 환경에서 AI 추론을 가속화하기 위해 설계된 프로세서로, 퀄컴(Qualcomm), 삼성(Samsung), 애플(Apple) 등이 개발하고 있습니다. FPGA(Field-Programmable Gate Array)는 특정 AI 모델이나 알고리즘에 맞게 하드웨어 구조를 재구성할 수 있는 유연성을 제공하여 초기 개발 및 특정 목적의 가속에 활용됩니다. 마지막으로 ASIC은 특정 AI 알고리즘이나 애플리케이션에 최적화된 맞춤형 칩으로, 대량 생산 시 비용 효율적이며 최고의 성능과 전력 효율을 제공합니다. 이러한 칩들은 AI 가속기 카드나 모듈 형태로 서버나 엣지 디바이스에 장착되어 AI 연산을 가속하며, 다수의 가속기를 통합한 AI 서버나 시스템 형태로 구축되기도 합니다.

AI 컴퓨팅 하드웨어는 광범위한 분야에서 활용됩니다. 데이터 센터 및 클라우드 컴퓨팅 환경에서는 대규모 AI 모델의 학습 및 추론 서비스를 제공하는 데 필수적입니다. 자율주행 분야에서는 실시간 센서 데이터 처리, 객체 인식, 경로 계획 등 복잡한 연산을 수행합니다. 의료 및 헬스케어 분야에서는 의료 영상 분석, 신약 개발, 질병 진단 보조 등에 활용되며, 스마트 팩토리 및 로봇 산업에서는 품질 검사, 예측 유지보수, 로봇 제어 등에 기여합니다. 스마트폰 및 엣지 디바이스에서는 음성 인식, 이미지 처리, 증강 현실(AR), 개인화 서비스 등을 구현하며, 금융 분야에서는 사기 탐지, 알고리즘 트레이딩, 신용 평가 등에 사용됩니다. 또한 보안 분야에서는 얼굴 인식, 침입 탐지, 영상 감시 시스템 등에 핵심적인 역할을 합니다.

AI 컴퓨팅 하드웨어의 성능을 극대화하기 위한 관련 기술들도 중요합니다. HBM(High Bandwidth Memory)과 같은 고성능 메모리는 AI 모델의 방대한 데이터 처리에 필수적인 고대역폭을 제공합니다. NVLink, InfiniBand 등 고속 인터커넥트 기술은 다수의 AI 가속기 간 또는 가속기와 CPU 간의 데이터 전송 속도를 극대화하여 시스템 전체 성능을 향상시킵니다. CUDA, OpenCL, TensorFlow, PyTorch 등 AI 모델 개발 및 배포를 위한 AI 소프트웨어 스택은 하드웨어의 잠재력을 최대한 활용할 수 있도록 지원합니다. AI 컴퓨팅 하드웨어는 높은 전력 소모로 인해 상당한 열을 발생시키므로, 액체 냉각(liquid cooling) 등 고급 냉각 기술 또한 필수적입니다. 최근에는 여러 개의 작은 칩을 하나의 패키지로 통합하여 성능, 전력 효율, 생산 유연성을 높이는 칩렛(Chiplet) 기술도 주목받고 있습니다.

AI 컴퓨팅 하드웨어 시장은 딥러닝 모델의 복잡성 증가, 데이터 양 폭증, AI 애플리케이션의 확산에 힘입어 폭발적인 성장을 거듭하고 있습니다. 현재 엔비디아(NVIDIA)가 GPU 시장을 압도적으로 지배하고 있으며, 인텔(Intel), AMD(Advanced Micro Devices)가 추격하고 있습니다. 구글(Google), 아마존(Amazon), 마이크로소프트(Microsoft) 등 주요 클라우드 기업들은 자체 AI 칩 개발에 적극적으로 투자하며 시장 경쟁을 심화시키고 있습니다. 삼성전자(Samsung Electronics), SK하이닉스(SK Hynix)와 같은 국내 기업들은 고성능 메모리 분야에서 핵심적인 역할을 수행하며 AI 하드웨어 생태계에 기여하고 있습니다. 범용 GPU 외에 특정 워크로드에 최적화된 ASIC, NPU 등의 개발 경쟁이 치열하며, 첨단 반도체 제조 공정의 복잡성과 지정학적 요인으로 인한 공급망 불안정성 또한 시장에 중요한 영향을 미치고 있습니다.

미래 AI 컴퓨팅 하드웨어는 지속적인 성능 및 효율성 향상을 추구할 것입니다. 더 높은 연산 능력과 더 낮은 전력 소모를 위한 하드웨어 아키텍처 혁신이 지속될 것이며, 양자 컴퓨팅과의 융합 가능성도 탐구될 수 있습니다. 데이터 센터 중심에서 벗어나 스마트폰, IoT 기기, 로봇 등 엣지 디바이스에서의 AI 연산 수요가 증가함에 따라 저전력, 고효율 NPU 및 엣지 AI 가속기 시장이 크게 성장할 것으로 예상됩니다. 특정 산업 또는 애플리케이션에 최적화된 ASIC 개발이 더욱 활발해지며, 하드웨어의 잠재력을 최대한 끌어내기 위한 소프트웨어 스택과의 긴밀한 통합 및 최적화가 더욱 중요해질 것입니다. 또한 AI 컴퓨팅의 막대한 전력 소모 문제를 해결하기 위한 저전력 설계 및 효율적인 냉각 기술 개발이 핵심 과제가 될 것이며, RISC-V와 같은 오픈소스 아키텍처를 기반으로 한 AI 칩 개발이 새로운 기회를 창출할 가능성도 있습니다.